Estábamos tan distraídos con el fin del mundo, que no nos dimos cuenta cuando los robots se apoderaron de todo.

Primero fue “Teatro de la ópera espacial”, la obra de Jason Allen que resultó ganadora del primer premio en la feria de arte estatal del estado de Colorado, en Estados Unidos, hace pocos meses. La obra parece un cuadro extraído de la más reciente película de Dune, un momento durante la performance desde el escenario de una colección de figuras humanoides frente a una orbe brillante en el fondo. Es una imagen que yo colgaría feliz en la sala de mi casa, que me podría imaginar encontrando en formato grande en una galería de arte o un museo.

Cuando Allen luego de ganar el premio reveló que la imagen había sido generada utilizando un algoritmo, estalló la controversia. ¿Puede un algoritmo generar arte? ¿Debería ese arte ganar premios?

Tan solo unos días después empezó a circular por la web el audio de una entrevista de Joe Rogan, uno de los podcasters más escuchados (y controversiales) del mundo, a Steve Jobs, el fallecido fundador y ex-CEO de Apple. O mejor dicho: el audio de una entrevista que nunca sucedió. El audio había sido generado por Play.ht, una empresa que utilizó un algoritmo para sintetizar las voces de ambos a partir del abundante material grabado que existe.

Poco después de eso apareció The Infinite Conversation, una conversación generada algorítmicamente entre el filósofo esloveno Slavoj Zizek y el cineasta alemán Werner Herzog que se extiende cada día para convertirse en un diálogo infinito utilizando sus voces simuladas. Giacomo Miceli, un programador creativo italiano, creó por sí solo esta obra como una manera de llamar la atención sobre lo fácil que es generar contenidos algorítmicos que resulten verosímiles y que para el ojo no entrenado resulten indistinguibles de textos y voces reales.

Todo esto pasó entre agosto y octubre del 2022. Nos distrajimos por un momento y de pronto estábamos rodeados de robots pintando cuadros y grabando podcasts.

Una breve historia de la inteligencia artificial

Si te pido que me traigas una silla, es bastante probable que sepas a qué me refiero. Pero si te pido que me definas qué es una silla, la cosa se pone bastante más complicada: suelen tener cuatro patas, pero podría tener cinco, dos, o una e igual sabes que es una silla. Puedes usarla para sentarte, pero una banca también serviría para eso, y si me paro encima de una silla no deja de ser una silla. Puede que sea de madera, pero también podría ser de metal, o de plástico. Nos es muy fácil reconocer una silla, pero habiendo tantas posibles variantes se vuelve sumamente difícil definir con claridad qué es una silla.

La investigación en inteligencia artificial lleva décadas sufriendo con problemas como éste. En los ochentas, los investigadores se dedicaron a construir “sistemas expertos”: bases de datos enormes que buscaban capturar en el mayor detalle posible todo el conocimiento disponible respecto a diferentes temas. Capturar por ejemplo todas las diferentes variables que consideramos al preguntarnos si una silla es una silla, para lograr que una computadora distinga una silla de una banca. Los sistemas expertos eran reconstrucciones digitales del conocimiento de la medicina, el derecho, la ingeniería, u otros disciplinas con la esperanza de que las computadoras pudieran replicar su toma de decisiones.

Como podrán imaginar, esto no funcionó del todo bien. Por un lado, capturar de manera comprehensiva el conocimiento en una disciplina era extremadamente difícil, por no decir imposible; por otro lado, todo ese trabajo servía para una sola categoría: sin importar cuán completo fuera el sistema experto en medicina, nada de ese trabajo era reutilizable para el sistema experto en repostería. El fracaso de los sistemas expertos llevó al “invierno de la inteligencia artificial”, un periodo de muchos años donde el nivel de investigación en este tema se redujo significativamente.

Hasta hace más o menos una década, cuando pasaron dos cosas: el costo de la computación se redujo a casi nada, y la disponibilidad de datos de todo tipo se incrementó de manera incalculable. De pronto Internet estaba lleno de información accesible públicamente. Entonces se volvieron viables los modelos estadísticos: en lugar de definir qué es una silla, puedo darle a una computadora un millón de imágenes de sillas y un millón de imágenes de no-sillas y decirle que las use para aprender a identificar sillas.

Esto es en esencia lo que hace el machine learning, o el aprendizaje automatizado: el algoritmo no tiene idea de qué es una silla, pero dada una imagen que no ha visto nunca antes puede determinar con un alto grado de confiabilidad si en esa imagen hay o no una silla, si la foto de una persona corresponde con quién dice ser, si el tono de voz en una llamada suena molesto o nervioso, o si una transacción financiera tiene riesgo de fraude.

Los algoritmos se volvieron muy buenos para clasificar cosas cuando podían ser refinados con cantidades absurdas de data de entrenamiento: el machine learning significó el final del invierno en inteligencia artificial.

La gran diferencia es que estos nuevos algoritmos no solamente sirven para clasificar datos, sino que generan información completamente nueva: pueden generar textos, imágenes, animaciones, videos que nunca antes existieron. A partir de una descripción que reciben como input, estos algoritmos pueden ser creativos, generativos. Y podemos dedicar muchísimo tiempo a discutir sobre qué es realmente la creatividad o si un algoritmo puede ser verdaderamente original, pero esas son conversaciones que funcionan mucho mejor con una (o más) botellas de vino.

Aquí lo que importa es que estos algoritmos están produciendo, ya no solo clasificando, y eso tiene una serie de consecuencias interesantes.

Cómo entrenar a tu algoritmo

En los últimos meses ha habido una explosión de algoritmos generativos para todo tipo de formatos. Entre los más populares están GPT-3 para texto; Stable Diffusion, Dall-E / Craiyon, y Midjourney para imágenes; Make-A-Video para video. Cada uno es un universo por sí mismo, con su propia curva de aprendizaje, modo de operación y comunidad detrás.

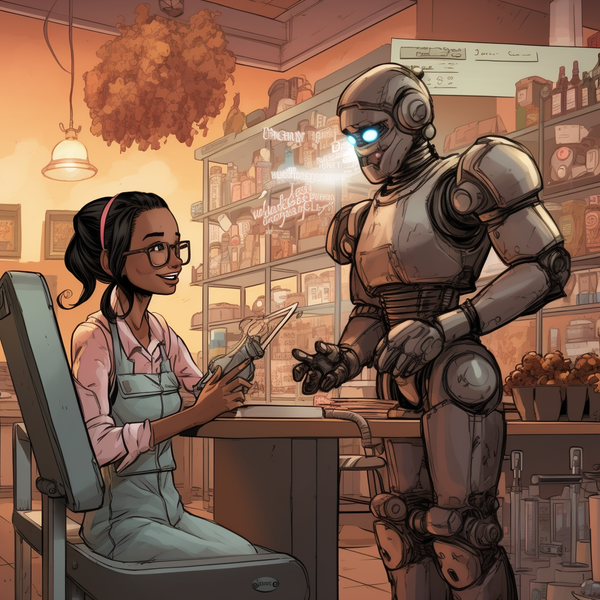

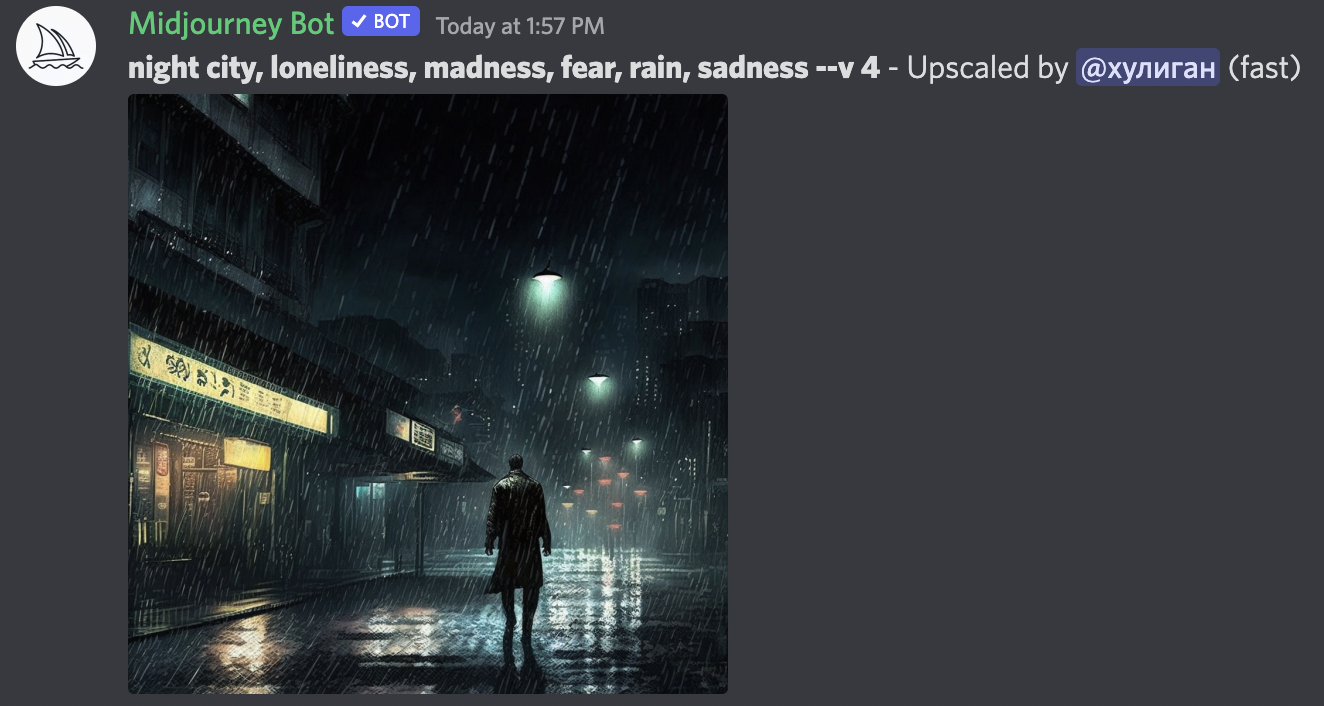

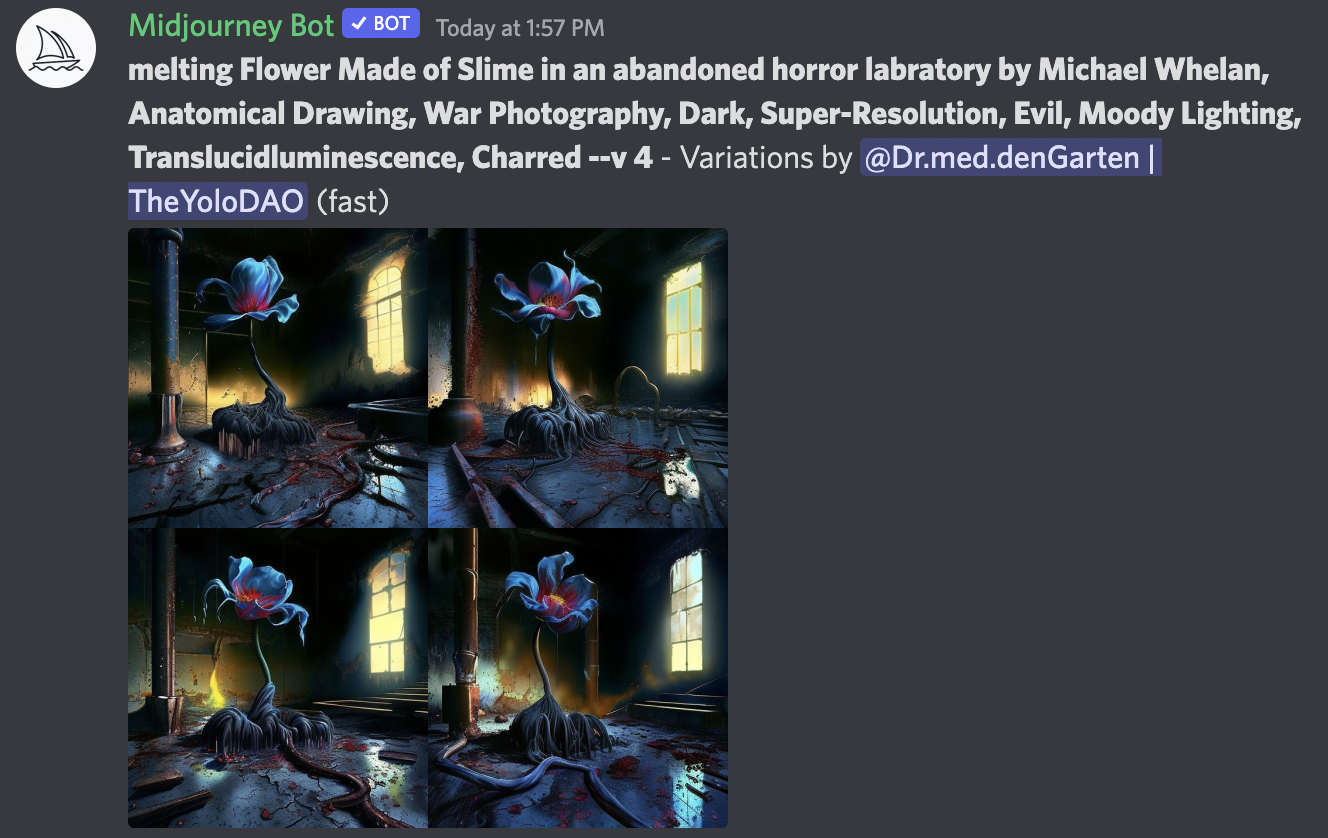

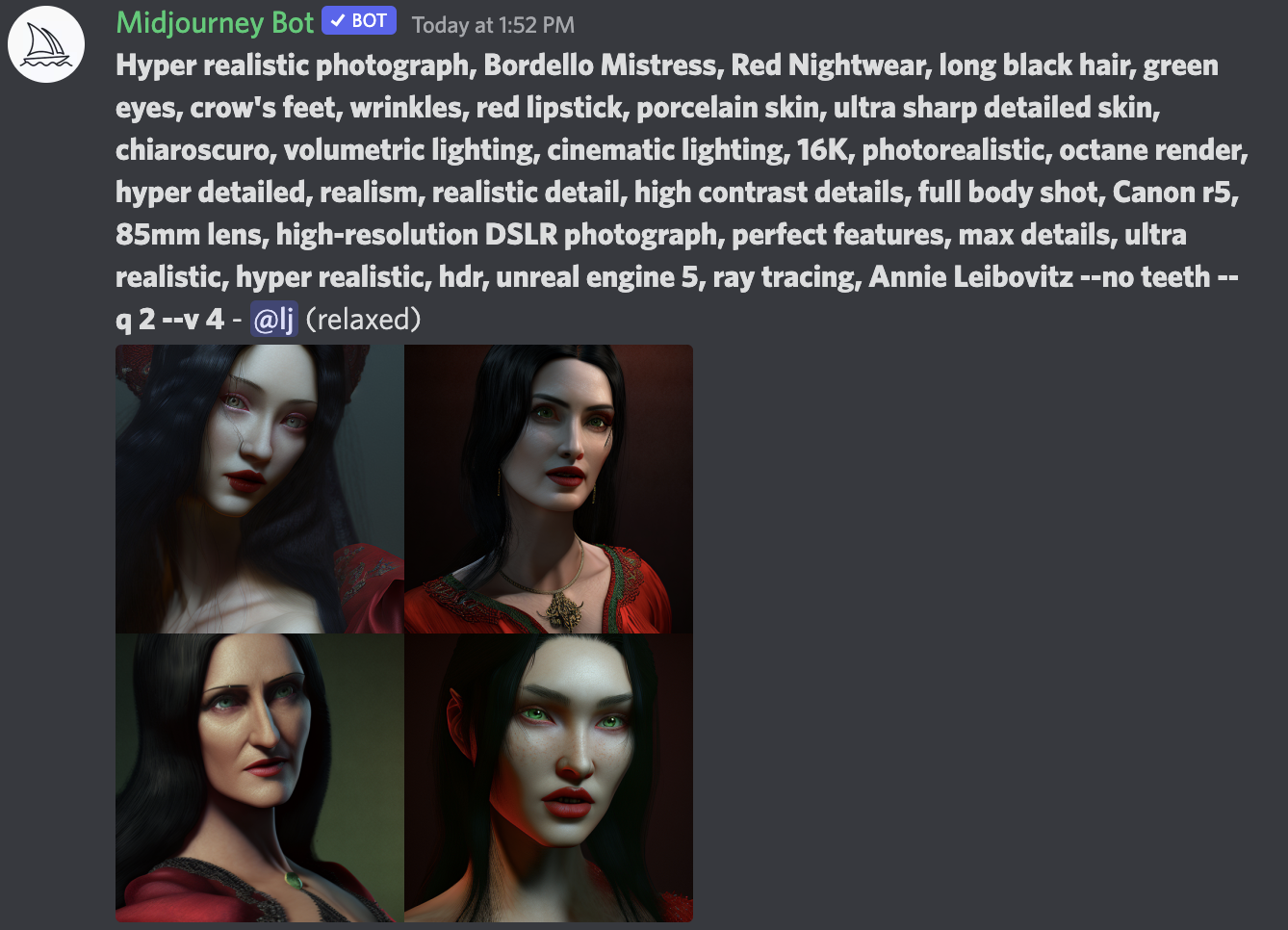

Así que para entender mejor el potencial de todo esto tuve que introducirme a jugar de cerca con alguno de ellos — y escogí jugar con Midjourney por la simple razón de que los resultados que había visto me parecían los más bonitos. La puerta de entrada al mundo de Midjourney es a través de su comunidad en Discord, una aplicación de chat muy popular entre comunidades de videojuegos y tecnología (algo así como el Teams para la generación Z). En los canales del Discord de Midjourney uno puede interactuar con el robot que genera imágenes, enviándole comandos con las instrucciones específicas que uno quiere generar.

Aquí es donde la cosa se pone interesante: la manera en la que uno genera imágenes con Midjourney es introduciendo descripciones no solo del contenido, sino también del estilo de la imagen. No hay un vocabulario específico que sea requerido, pero viendo las descripciones que comparte la gente en los canales del Discord uno empieza a entender el tipo de parámetros que puede utilizar: quizás una imagen ultrarrealista, o quizás todo lo contrario, una imagen al estilo de Pixar. Quizás una fotografía, o una ilustración, quizás una composición abstracta. No hay ningún límite, pero obtener el resultado deseado depende de aprender a jugar con todas las posibilidades para ir refinando la imagen resultante. La descripción puede ser de una línea, o de un párrafo. Puede ser literal y específica, o metafórica y abierta. El robot de Midjourney devuelve una colección de imágenes propuestas con la opción de generar variaciones, o versiones de mayor resolución.

Las primeras 25 imágenes son gratuitas. Luego de eso, el usuario tiene que pagar una suscripción que empieza en $10 al mes para seguir generando nuevas imágenes — y creo que nunca he pagado por una suscripción más rápido que por Midjourney. Los resultados no solo son espectaculares, sino que toda la dinámica es adictiva: es casi como jugar un juego en el que tienes que refinar la manera en la que describes una imagen que tienes en la cabeza para que el algoritmo sepa cómo interpretarla. Es algo así como jugar Pictionary con una inteligencia artificial: aprender a comunicarse de manera creativa con un algoritmo.

No es difícil producir imágenes de suficiente calidad que uno quiera compartir. Ciertamente es muy fácil generar imágenes que serán mucho mejores que lo que la mayoría de personas seríamos capaces de hacer de manera tradicional. Sobre todo, hacerlo a una fracción de tiempo e inversión: la mayoría de imágenes se generan en pocos segundos, a lo mucho pocos minutos si se trata de una descripción muy compleja. Lo cual hace que iterar diferentes descripciones sea muy sencillo. Entre las comunidades de personas jugando con estas herramientas se ha vuelto común compartir no solo las imágenes, sino también la descripción utilizada para generarla: es la manera a través de la cual las personas pueden descubrir cómo mejorar su dinámica de Pictionary con el algoritmo.

¿Sueñan los androides con ovejas eléctricas?

Para la mayoría de nosotros, estas imágenes son indistinguibles de algo que podría haber producido un artista real. Seguramente un especialista podría notar los detalles que muestran la línea que aún separa la realidad del artificio, pero la mayoría de nosotros no podríamos hacerlo. Los algoritmos generativos se están volviendo más sofisticados en un momento en el que es más difícil que antes distinguir lo verdadero de lo falso, y cuando esto está teniendo consecuencias que van mucho más allá de lo tecnológico.

En 1935, el filósofo alemán Walter Benjamin publicó “La obra de arte en la época de su reproducibilidad técnica”, un ensayo que reflexionaba sobre cómo cambia el arte en un mundo en el que la fotografía se vuelve algo normal. Cuando una fotografía puede capturar el mundo “real” mejor que cualquier artista, y esa fotografía puede además reproducirse masivamente sin perder calidad en el proceso, ¿cuál se vuelve entonces el rol del arte?

Algo parecido ocurre con los algoritmos generativos — podemos generar todo tipo de imágenes que pueden tener todo tipo de efectos. ¿Qué significa esto para el arte? ¿Cómo afecta o transforma la manera en la que trabajan los artistas, tradicionales o digitales, el contar con estas herramientas?

Es más, ¿cómo afecta esto a todo tipo de roles y procesos creativos? Un escritor es perfectamente capaz de generar las ilustraciones para su propio libro, un guionista puede generar los storyboards para imaginar cómo podría verse su película. Es fácil de imaginar que no pasará mucho tiempo hasta que los algoritmos que generan video tengan suficiente calidad como para generar películas y secuencias animadas de alta calidad, y veamos las primeras producciones audiovisuales generadas algorítmicamente — de pronto podemos imaginarnos un futuro en el que toda una película es producida por una sola persona.

Pero quizás donde todo esto introduce distorsiones más profundas es en el ámbito político y democrático. Hemos visto ya en los últimos años como absolutamente todas las democracias se están viendo afectadas por la polarización de los algoritmos en redes sociales y la facilidad de crear noticias falsas que viajan a la velocidad de la luz. Ya hoy día tenemos dificultades para distinguir lo verdadero de lo falso con la cantidad de desinformación que está en circulación. Con algoritmos generativos cada vez más sofisticados y accesibles, esto solamente tenderá a ponerse peor: entramos en la época del propagandismo distribuido, cuando cualquier persona virtualmente podría convertirse en una fábrica de desinformación a escala.

El amor en los tiempos del metaverso

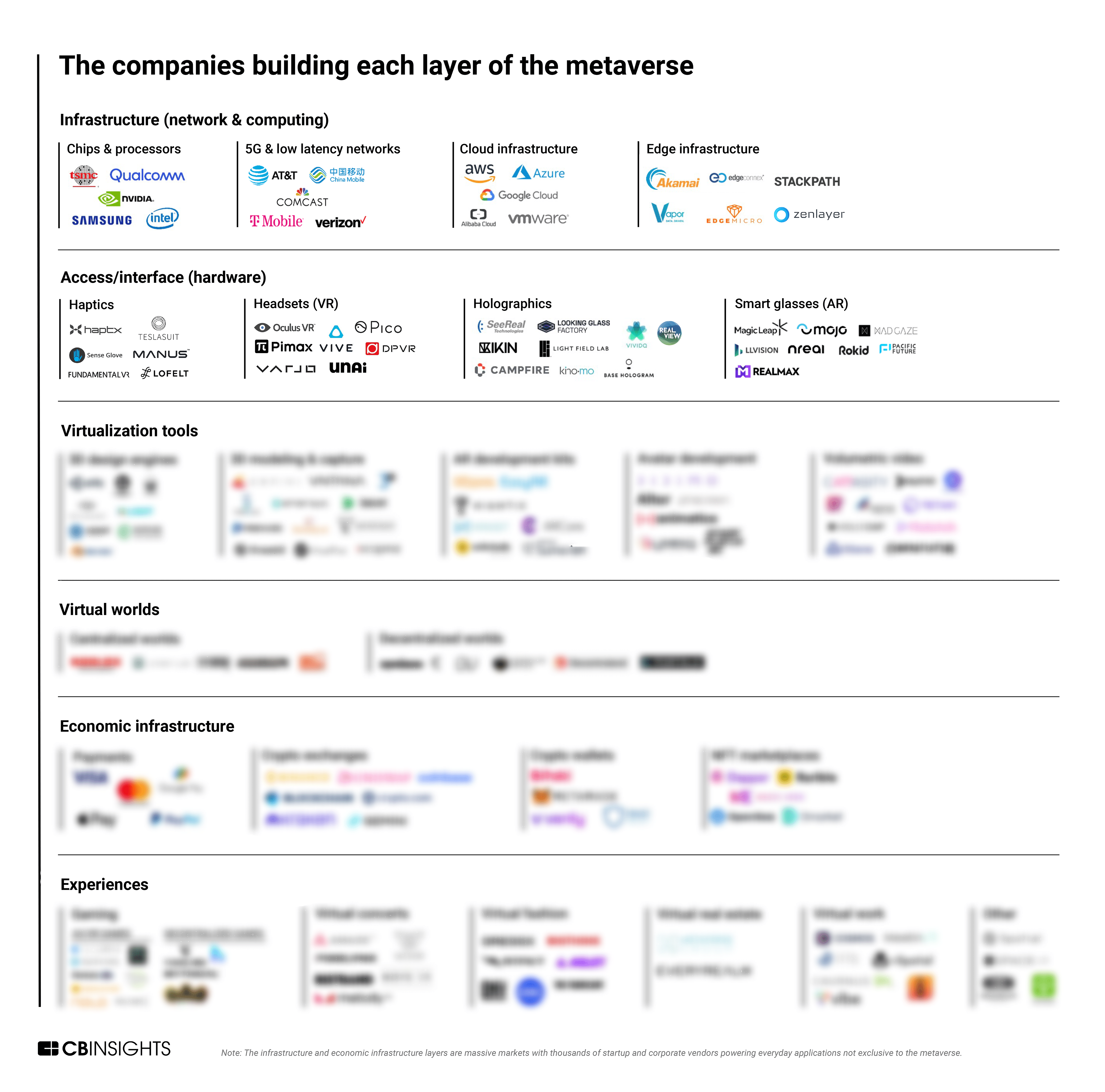

Pero nuestra realidad ya estaba bajo el asedio de la tecnología desde hace buen tiempo, especialmente con todo el interés que estaba acumulando el metaverso, eso que nadie sabe bien qué es pero todo el mundo quiere decir que está haciendo.

El metaverso es un concepto paraguas que nos permite hablar sin mucha precisión sobre un conjunto de tecnologías y conductas: cosas como realidad virtual, realidad aumentada, videojuegos y mundos virtuales. Cuando hablamos de metaverso hablamos de cómo los mundos virtuales de los que participamos se vuelven cada vez más complejos y “reales” porque nos permiten hacer cada vez más cosas, y cómo nuestro mundo real se vuelve cada vez más virtual porque podemos integrar capas de información digital en nuestra vida cotidiana.

Quien ha hecho hasta ahora la apuesta más extravagante por el metaverso es Mark Zuckerberg, que el año pasado cambió el nombre de Facebook a Meta para decirle al mundo cuán importante sería el metaverso para el futuro de su empresa. Desde entonces la empresa ha invertido un aproximado de $10 mil millones en desarrollos para el metaverso en un intento desesperado por activar una nueva línea de negocios que salve su futuro, a medida que sus ingresos por publicidad en todas sus plataformas se reducen progresivamente (Meta tuvo que despedir alrededor de 11,000 personas en noviembre ante una difícil situación financiera).

El problema del metaverso de Mark es que no es particularmente emocionante. En el evento de Meta en el que anunciaron sus últimas novedades hace unas semanas, los anuncios incluyeron un nuevo casco de realidad virtual de $1500 y una alianza con Microsoft para llevar llamadas de Teams a Horizon Worlds, el mundo virtual de Meta — lejos, muy lejos de la fantasía digital de películas como Ready Player One. Quizás el gran problema sea que Meta ha decidido apostarlo todo por el metaverso sin que quede claro por qué: este es el mundo de Mark y todos los demás, usuarios y empleados, son solamente visitantes.

Pero que el metaverso de Mark sea aburrido no quiere decir que el metaverso en sí no sea interesante — es solo que lo interesante del metaverso no está en la utopía corporativa que nos quiere vender. La forma temprana de todo medio es siempre el medio anterior: las reuniones de Teams en el metaverso son comparables a las primeras producciones para la televisión que no eran más que novelas de radio con una cámara al frente. Cada vez que un banco anuncia que está abriendo una sucursal en el metaverso hay un momento incómodo en el que nadie se atreve a preguntar, “¿pero para qué?”.

La verdad de la milanesa es que estamos ante la primera generación de experimentos — los raros, los incómodos, los que en el futuro querremos olvidar así como queremos olvidar los peinados de los ochentas o la ropa color neón de los noventas porque estábamos “pasando por una etapa”. El metaverso está pasando por esa etapa: las plataformas están experimentando, los usuarios están experimentando, y nuevas tecnologías están permitiendo nuevas cosas. Hay un punto de encuentro muy prometedor entre los algoritmos generativos y los mundos virtuales para generar entornos completamente nuevos e inesperados; hay el potencial para generar experiencias completamente nuevas que pueden habitarse y recorrerse.

Una nueva tecnología en desarrollo, los Neural Radiance Fields (NeRFs) o “campos de radiación neuronal”, permiten la rápida generación de entornos tridimensionales a partir de imágenes bidimensionales. Con todas las piezas combinadas, esto quiere decir que en teoría podremos no solamente generar imágenes algorítmicamente, sino entornos virtuales completamente navegables o secuencias animadas a partir de imágenes estáticas. El texto se vuelve una foto; la foto se vuelve una película, o se vuelve entorno interactivo.

En 1997 Janet Murray publicó Hamlet on the Holodeck, uno de los primeros y más importantes textos sobre literatura interactiva. “Me encuentro a mí misma anticipando un nuevo tipo de narrador de historias”, escribió entonces, “uno que sea mitad hacker, y mitad bardo”. Murray documentó las maneras tempranas en las que la tecnología digital estaba transformando la manera en la que contábamos historias, haciéndolas más inmersivas, interactivas, y dinámicas — haciendo referencia al holodeck, la tecnología imaginaria de Star Trek que permitía recrear entornos holográficos fantásticos en los que las personas podían introducirse y participar.

Sería ingenuo decir que estamos presenciando el nacimiento del holodeck; pero no sería exagerado decir que la combinación de todas estas cosas — algoritmos generativos, realidad extendida, mundos virtuales, videojuegos, campos de radiación neuronal — van a producir experiencias narrativas completamente nuevas en los próximos años: realidades sintéticas. Estamos potencialmente ante el nacimiento de un nuevo medio que hoy día solo sabemos interpretar a partir de categorías conocidas para el trabajo y el entretenimiento, pero sus posibilidades son mucho más grandes — y van a requerir de toda una nueva infraestructura productiva: nuevos roles, nuevas herramientas, nuevos procesos de producción, nuevos modelos de negocios. Es quizás considerando todo eso que hay quienes consideran que el metaverso, incluso sin saber bien qué significa, podría representar un mercado de $1 billón — un billón de verdad, no uno de esos billones anglosajones. Pero desarrollar la capacidad para capturar una parte de ese mercado no es un esfuerzo ni una inversión menor.

¿Y ahora qué hago?

Si bien el potencial de las realidades sintéticas es enorme, es también un ámbito complejo en el que es fácil perderse, o no saber por dónde empezar — incluso no saber si uno tendría que estar interesado o no. Estas preguntas están pensadas para servir como una guía para empezar a pensar en la relevancia de estas tecnologías para tu equipo, organización, o industria.

1. ¿Cómo afecta esto la experiencia de tus usuarios?

Estas son tecnologías emergentes que recién están empezando a cobrar forma, pero es fácil imaginar cómo pueden tener un impacto directo en la experiencia de las personas en algunas industrias — especialmente en aquellas en las que el contenido y la experiencia son una parte integral del servicio (o son el servicio mismo). Industrias como el entretenimiento, la educación, la moda, los servicios, o la hospitalidad son ejemplos donde el contenido y la experiencia son la propuesta de valor, y cualquier tecnología que los afecte tendrá una especial relevancia.

Por otro lado, estas tecnologías no necesariamente serán buenas interfaces transaccionales. La idea de una sucursal bancaria en el metaverso es rara porque un mundo virtual no es necesariamente una mejor manera de interactuar con un servicio financiero que una aplicación móvil. Hay límites a cuánto queremos optimizar nuestra experiencia de comprar tomates. Para industrias y modelos de servicio optimizadas para lo transaccional, el potencial de las realidades sintéticas y el metaverso podría ser limitado.

2. ¿Cómo afecta esto la organización de tus operaciones?

Aún si estas tecnologías no varían significativamente cómo interactúas con tus usuarios, sí podrían afectar de manera importante la manera en la que trabajamos y nos organizamos. El trabajo apoyado por algoritmos e inteligencia artificial es ya bastante común, aún cuando nos resulte invisible: herramientas cotidianas como Google Docs, Excel, o Figma ya incluyen diferentes optimizaciones utilizando algoritmos para hacernos el trabajo más fácil. Pero esto inevitablemente tiene que volverse verdadero para tus desarrollos internos: toda herramienta que utilices para fines internos tiene el potencial de repensarse utilizando algoritmos de inteligencia artificial para identificar información relevante o para generar contenidos. Es posible imaginar sistemas de servicio al cliente capaces de resumir una conversación telefónica, combinarla con enlaces a recursos de interés, y enviarlo todo al cliente por correo electrónico al finalizar su interacción.

Este potencial solo puede aprovecharse si tu infraestructura tecnológica y tu cultura están abiertas a la experimentación a escala. Ser una organización que sabe aprovechar la inteligencia artificial no quiere decir tener un equipo de Analytics o un Chief Data Officer: quiere decir que las posibilidades algorítmicas están distribuidas a través de toda la operación de la organización.

3. ¿Cómo estás haciendo tus apuestas/experimentos?

Es muy fácil meter la pata cuando se juega con conceptos tan nuevos. Hay muchas cosas que saldrán mal, sea porque no funcionan o porque funcionan pero terminan siendo… raras. Todo eso está bien y es parte del proceso de aprendizaje.

La clave, sobre todo en esta etapa cuando nadie sabe bien qué está pasando, es saber hacer múltiples pequeñas apuestas en lugar de grandes inversiones. Mark Zuckerberg se está jugando todas las fichas, y eso hace que todos sus errores de cálculo se conviertan en noticias de primera plana. Hasta que tengas un cuerpo de aprendizajes suficientemente sólido para saber qué significan estas tecnologías para tu negocio, es mejor apostar poco y a pequeña escala. Experimenta para aprender y refinar, no necesariamente para vender y tener una propuesta exitosa de inmediato.

Es tentador decidir hacer un experimento y soltar una nota de prensa hablando de la importancia del metaverso y del compromiso de tu organización con el futuro — pero esas cosas no te ayudan. Ponen presión innecesaria por mostrar resultados específicos, y en la práctica limitan la capacidad de tu equipo para aprender y cambiar de rumbo si es necesario.

/cdn.vox-cdn.com/uploads/chorus_asset/file/22888569/acastro_210929_4779_0001.jpg)