Si seguimos hablando sobre inteligencia artificial, es porque esto es kind of a big deal. Todo está pasando en todas partes al mismo tiempo, muy rápidamente, y con poca capacidad de respuesta. Estamos recibiendo todos estos discursos de que tenemos que ponernos al día, actualizarnos, aprender, incorporar, y todo esto es verdadero — pero se puede sentir bastante abrumador.

Estas nuevas tecnologías de automatización van a tener impactos en muchos niveles. No solamente en cómo trabajamos: van a tener un impacto a un nivel societal, van a tener un impacto en la manera como se configura la economía, en nuestras interacciones políticas, en nuestras relaciones con las instituciones. Estamos frente a un nuevo paradigma tecnológico que puede compararse a la introducción del Internet hace unas décadas. Por eso estamos empezando a ver que nuestra capacidad colectiva para hacer sentido de estas nuevas tecnologías no está necesariamente a la altura de las circunstancias.

Nos está costando mucho pensar en qué instituciones, procesos, sistemas o capacidades necesitamos para maximizar los impactos positivos que pueden tener estas tecnologías, mientras que al mismo tiempo mitigamos los impactos negativos que inevitablemente van a tener también. Las nuevas tecnologías no son solamente mejoras, sino que son siempre una suma compleja de sumas y restas, donde hay ganadores y perdedores, donde hay beneficios y perjuicios que tenemos que anticipar.

Por eso esta semana quiero desempacar algunos de los impactos más importantes y complejos que va a tener la inteligencia artificial en nuestra sociedad, y para los cuales vamos a necesitar una respuesta desde el punto de vista regulatorio: pensar en cuáles son las políticas, las leyes o los organismos que se van a tener que encargar de mitigar estos impactos o encaminarnos hacia el mejor uso posible de estas nuevas tecnologías. Ya estamos empezando a ver a través de la región cómo diferentes países están haciendo su mejor esfuerzo por construir bases regulatorias que nos permitan entender qué hacer — al mismo tiempo que somos conscientes de que en todo el mundo las instituciones que tienen a su cargo este tipo de regulación no necesariamente tienen las herramientas y las capacidades para tomar las mejores decisiones.

Vamos a explorar cuatro dimensiones relevantes al futuro de la inteligencia artificial:

- La propiedad intelectual y el scraping de información pública que alimenta el entrenamiento de estos algoritmos.

- La manera como la automatización va a reemplazar empleos a gran escala y la manera como eso va a crear nuevos problemas de inclusión y de desigualdad.

- El desafío de cómo nos aseguramos de que estos algoritmos son transparentes en su entrenamiento y en su alineamiento con diferentes creencias y conjuntos de valores.

- La manera como van a tener un impacto en nuestra conversación democrática y política, y el riesgo de vernos inundados por fake news y desinformación.

Estos son desafíos bastante grandes frente a los cuales vamos a tener que realizar mucha investigación, tener muchas conversaciones y finalmente desarrollar políticas públicas y marcos regulatorios que van a involucrar a múltiples actores. Para poder hacer eso tenemos que empezar entendiendo qué es eso que estamos regulando, qué está en juego y cuáles son las diferentes piezas de rompecabezas que tenemos que acomodar.

Un nuevo futuro del trabajo (más allá del trabajo híbrido). El trabajo remoto ya no es suficiente. El futuro del trabajo va a ser redefinido por nuevas tecnologías, límites claros y una cultura laboral diversa.

Central y la comida como una industria creativa. ¿Cuáles han sido los elementos que contribuyeron a la evolución de la industria gastronómica peruana como una industria creativa?

Diez libros para entender mejor el futuro. Una colección de libros no-evidentes para entender mejor cómo funcionan la innovación y la transformación, y cómo las personas hacemos sentido de un mundo que cambia demasiado rápido a nuestro alrededor.

Nuestros suscriptores pagados tienen acceso a todo nuestro archivo de historias pasadas, así como a nuestras masterclasses y otras cosas divertidas — además de que nos ayudan a alimentar a nuestros mutitos. Ya que estás por aquí, puedes aprovechar para suscribirte.

¿Quién tiene acceso a la data?

Empecemos entendiendo lo siguiente: los modelos generativos, como ChatGPT y otros parecidos, son capaces de generar contenidos nuevos porque han consumido enormes cantidades de información que son luego procesadas para entrenar a estos algoritmos. Esencialmente lo que han hecho es leer una buena parte de la internet pública para utilizartoda esa información de miles de millones de páginas web al decidir cuál es la respuesta que mejor responde una instrucción que recibe del usuario. Han consumido tantas cosas que tienen un catálogo gigantesco desde el cual aprender y disponer para generar esas respuestas.

Para hacer esto, organizaciones como OpenAI o Google, entre otras, están consumiendo enormes cantidades de información pública que no fue hecha pública para esos fines. Es la propiedad intelectual de otras personas y organizaciones que está siendo utilizada para entrenar a estos algoritmos. Por eso, plataformas que tienen enormes catálogos de contenido como Reddit o StackOverflow han protestado de manera muy legítima porque su principal activo está siendo monetizado por otras organizaciones sin ningún tipo de autorización ni menos compensación.

Japón está en proceso de adoptar una política controversial según la cual la propiedad intelectual no alcanza al contenido utilizado para entrenar algoritmos de inteligencia artificial. Una decisión que va en contra del reclamo de múltiples artistas y organizaciones que, más bien, quieren ser reconocidos y compensados por el trabajo creativo que ahora está siendo minado algorítmicamente por las empresas de tecnología.

Los algoritmos necesitan de la información para poder ser entrenados, y están generando valor a partir de su uso. Ponerle candados a la data inevitablemente va a resultar en una menor capacidad para que estos algoritmos puedan evolucionar más rápidamente. Pero si los algoritmos tienen completa libertad para consumir todo aquello que puedan minar, estamos perjudicando a todas esas personas que han generado ese contenido con mucho esfuerzo durante mucho tiempo, y que han invertido recursos en la construcción de estas grandes colecciones de información.

¿Qué va a pasar con mi trabajo?

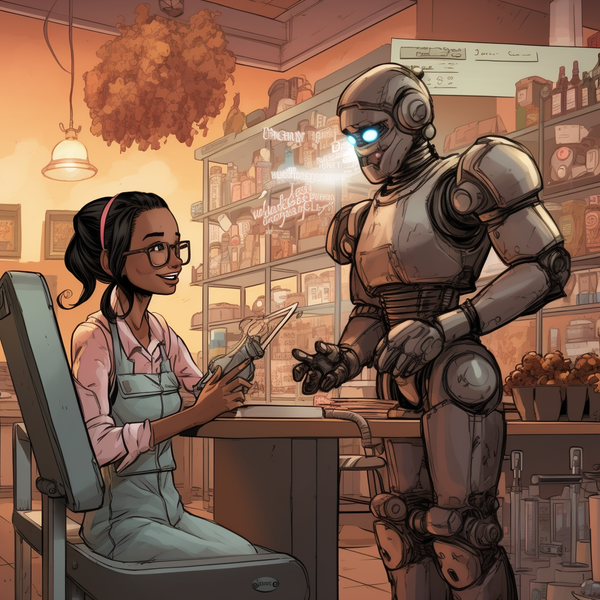

El segundo problema regulatorio que vamos a tener que enfrentar es ese que nos preocupa a todos: cuál va a ser el impacto de estas tecnologías en el empleo.

La inteligencia artificial y las diferentes herramientas que han aparecido afectan la manera como trabajamos: nos permiten ser más productivos, ser más creativos, ahorrar tiempo — pero todo eso que significa un beneficio a escala individual se ve de manera muy diferente cuando hacemos zoom out y vemos la figura completa. Es inevitable que la inteligencia artificial se convierta no en una ventaja competitiva en el mercado, sino en una línea de base para la productividad. De la misma manera que hoy utilizamos procesadores de texto y hojas de cálculo, vamos a utilizar asistentes virtuales y automatizaciones que nos ayudan a hacer cosas como parte normal de lo que significa trabajar. Eso termina ejerciendo una presión muy fuerte sobre cómo las organizaciones estructuran su producción: Si las mismas personas ahora pueden tener más y mejores resultados utilizando menos recursos, las organizaciones empiezan a sentir presión para trabajar con equipos más chicos o dejar ir a ciertas personas porque ahora pueden ser más productivas, todo al servicio de la eficiencia.

Esto no es un impacto tecnológico inevitable: es el resultado personas tomando decisiones, no de fuerzas de la naturaleza. Son las personas que dirigen estas organizaciones las que van a finalmente decidir que pueden optimizar costos o dejar ir gente, en lugar de decidir trabajar menos o distribuir la producción de una manera más inteligente — porque tenemos las herramientas que nos permiten hacerlo. Esta no es una preocupación abstracta: es justamente esta tensión la que estamos observando en la huelga de escritores en Estados Unidos: la preocupación que está al centro de las demandas del sindicato de escritores es la necesidad de establecer límites claros a cuánto y cómo los estudios utilizarán inteligencia artificial para generar nuevos contenidos. O el catalizador de que organizaciones como BuzzFeed eliminen su división de noticias para reemplazarla por contenidos generados por algoritmos.

Habiendo dicho eso, sí tenemos que reconocer que inevitablemente muchos empleos se van a volver obsoletos debido al acceso a estas nuevas herramientas — así como se van a crear también muchos empleos y roles, nuevas categorías que hoy día no conocemos. Pero desde un punto de vista macro, tenemos que empezar a pensar en cómo vamos a gestionar este cambio. ¿Cómo vamos a ayudar a las organizaciones a incorporar estas tecnologías para que se mantengan competitivas? ¿Cómo vamos a ayudar a los trabajadores a incorporar estas habilidades para que puedan seguir sumando? ¿Cómo vamos a mitigar a nivel social el impacto de que muchas personas van a verse afectadas por la pérdida de su trabajo como resultado de la incorporación de la inteligencia artificial?

Estamos ante una reconfiguración muy amplia de nuestra economía y de nuestro tejido laboral, que va a permitir a muchas organizaciones chicas y medianas a lograr cosas que antes solo eran posibles para organizaciones más grandes, y empezar a construir más valor con muchos menos recursos. Pero al mismo tiempo tenemos que lidiar con el impacto inevitable que vamos observar en la reconfiguración del empleo.

¿Cómo toman decisiones los algoritmos?

Un tercer desafío regulatorio va a ser transparentar cómo estos algoritmos son entrenados, qué información es utilizada para que tomen decisiones, y quién decide qué tipo de creencias y valores se ven reflejados en sus respuestas. Desde todos los lados del espectro ideológico han salido las acusaciones de que ChatGPT está muy sesgado hacia la izquierda o hacia la derecha, y estas percepciones van a ser siempre inevitables. Estos sistemas complejos pasan por largos y difíciles procesos de entrenamiento, donde son seres humanos quienes finalmente ponderan qué información es más o menos verdadera, debe ser más o menos considerada, y qué tipo de cosas se pueden o no se pueden hacer o decir.

(De hecho, una de las cosas que hemos visto en los últimos meses es el esfuerzo significativo de muchas personas para lograr que estos sistemas digan cosas que no deberían decir o compartan información que no deberían compartir, como secretos nucleares o la receta para producir napalm.)

Todo esto tiene consecuencias importantes para nuestra vida colectiva — especialmente a medida que involucramos algoritmos cada vez más en la toma de decisiones en todo tipo de sistemas privados y públicos. ¿Qué valores se van a utilizar para tomar decisiones utilizando estas herramientas? ¿Qué sesgos humanos se están viendo reproducidos de manera algorítmica? ¿Cómo tenemos acceso a saber de qué manera estos sistemas están tomando decisiones? ¿Cómo podemos supervisarlos efectivamente?

Las organizaciones que están desarrollando estos modelos están prestando muchísima atención al tema de la ética y la gobernanza, y a asegurarse de que existan límites a las capacidades de lo que estas herramientas pueden hacer. Pero desde donde estamos parados todos los demás, es difícil saber exactamente qué significa eso… ¿Qué procedimientos están en juego? ¿Quiénes toman las decisiones? ¿Cuáles son las diferentes ponderaciones que utilizan los modelos para decir más de una cosa o menos de la otra? En algún momento tenemos que tener una conversación grande y complicada respecto a cuáles son los mecanismos correctos de transparencia y accountability que deben existir para garantizar la confianza de las personas y de las instituciones.

Algunas de estas organizaciones han empezado a formar cuerpos colectivos desde los cuales puedan tomar decisiones conjuntas respecto al uso ético y a la normatividad bajo la cual van a desarrollar estas herramientas. Google, Microsoft, Anthropic, y OpenAI han creado el Frontier Model Forum para este propósito. Y si bien esto parece ser una buena idea, es también un arma de doble filo. En primer lugar porque sirve para crear una barrera entre organizaciones que tienen una cierta ventaja en la carrera y organizaciones más chicas como startups o equipos de software libre que están trabajando en modelos de lenguaje y que no participan de estas conversaciones.

Pero en segundo lugar es problemático porque están buscando llenar el vacío regulatorio con la promesa de la autorregulación, de que estas organizaciones pueden ponerse de acuerdo en que no van a hacer cosas malas y todos los demás tendríamos que confiar que ese va a ser el caso. Sabemos bien que la regulación institucional por parte de los gobiernos no es siempre la más efectiva, pero también es cierto que por lo menos existen mecanismos de control y supervisión que le dan al público una cierta garantía sobre el proceso de una manera que no es posible con un cuerpo colegiado autorregulatorio.

¿Cómo sabremos qué cosas son reales?

El cuarto problema que tenemos que considerar es el de las fake news y de la desinformación. En los últimos años hemos visto las redes sociales inundadas por todo tipo de campaña desinformativas, páginas web, tweets (¿xeets?), mensajes reenviados infinitamente en grupos de WhatsApp familiares donde todos tenemos un tío o una tía que alguien siempre tiene que defender diciendo “pero es buena gente”. Ahora con inteligencia artificial, el tío facho del grupo familiar de WhatsApp va a ser amplificado exponencialmente.

Hace unos meses se volvieron famosas las imágenes del Papa Francisco con un abrigo Balenciaga, o las que mostraban un violento arresto de Donald Trump por el FBI — todas ellas generadas utilizando MidJourney. El esfuerzo necesario para crear desinformación se ha reducido drásticamente, y las herramientas que lo permiten se siguen volviendo más complejas y de mayor fidelidad — permitiendo generar no solo textos e imágenes, sino también audios y videos. Nos vamos a encontrar inevitablemente inundados por enormes cantidades de información falsa porque cualquier persona va a poder operar un centro de propaganda en miniatura desde su laptop.

El Papa Francisco con su abrigo Balenciaga y Donald Trump arrestado por el FBI. Imágenes generadas con Midjourney.

Esto tiene consecuencias muy graves para nuestra vida democrática. Cuando podemos inundar el discurso público con información falsa con tanta facilidad, vamos a encontrarnos unos a otros pasando cada vez más tiempo validando o desmintiendo información que encontramos en internet. No vamos a tener de dónde aferrarnos para saber si el contenido que se rebota es realmente verdadero. Mientras más normal se vuelve la desinformación, más difícil se vuelve que habitemos en la misma realidad compartida — y, en consecuencia, que podamos ponernos de acuerdo incluso sobre las cosas más simples.

De modo que tenemos que hablar sobre qué vamos a hacer al respecto — si esto requiere de algún tipo de regulación, de alguna respuesta institucional, de una política educativa. No hay una respuesta clara sobre qué podemos hacer, considerando además que es un tema muy sensible porque choca con todas las preocupaciones legítimas que tenemos y deberíamos tener respecto a la libertad de expresión. No podemos simplemente prohibir el uso de estas herramientas, o prohibirlas para ciertos fines, porque la posibilidad de usos negativos no no debería pesar más que su potencial para usos positivos que van a generar muchísimo valor.

Estas son preguntas demasiado grandes

Si llegamos a un punto en el que desarrollamos una inteligencia artificial general, que desarrolla la capacidad para volverse consciente de su propia consciencia o al menos de aparentar que lo hace, ¿cómo vamos a lidiar con eso? ¿Qué tipo de límites vamos a poner? ¿Qué tipo de derechos o atribuciones deberían tener?

Yo soy consciente que todas estas preguntas son muy abstractas, incluso lindando con lo filosófico — y quizás por eso es que me entretienen tanto. Pero son también preguntas reales, cuyos efectos tangibles ya estamos observando alrededor del mundo. La inteligencia artificial es un factor en la huelga de escritores, en el despido de trabajadores, en las leyes que están formulando diferentes países, en su uso en el discurso político, en las imágenes del Papa con su abrigo Balenciaga. Todas estas señales no son especulativas: son cosas que están pasando hoy. Son temas para los que nuestros legisladores y nuestros organismos regulatorios van a tener que volverse competentes sumamente rápido para poder tomar buenas decisiones — o al menos para no tomar malas, que limiten la innovación y el potencial radical de estas tecnologías. Son ámbitos donde necesitamos de nuevos profesionales y nuevos expertos que empiecen a investigar y desarrollar puntos de vista que informen la manera como tomamos decisiones.

Cada uno de estos temas amerita una exploración profunda. Pero quería al menos empezar con una revisión rápida de algunos de los problemas más grandes que vamos a tener que resolver, cuál es la complejidad que está involucrada y por qué tendría que interesarnos no solamente como profesionales y como trabajadores sino también como ciudadanos. Estos son problemas reales para los que no estamos listos. Problemas para los cuales nuestro liderazgo político ciertamente no está listo, y eso debería darnos muchísimo miedo: porque es esa capacidad para gestionar bien esta transformación, en toda su complejidad, lo que en buena medida va a determinar si es que las sociedades de América Latina son solo observadoras de una transformación global, o si tienen las condiciones para asumir un rol de liderazgo en una conversación global.

/https%3A%2F%2Ftf-cmsv2-smithsonianmag-media.s3.amazonaws.com%2Ffiler_public%2F52%2Fe7%2F52e76a3c-4e16-430f-b5d6-b097c3450b65%2Fgettyimages-1243945263.jpg)

[Fast Company] Computer scientists claim to have discovered ‘unlimited’ ways to jailbreak ChatGPT

[Fast Company] BuzzFeed News is closing up shop as the company nurses its bottom line, enlists ChatGPT

- UTEC Ventures está buscando la próxima generación de fundadoras femeninas. ¿Quieres conocer más? Más info aquí

- El BID está buscando un nuevo rol: Division Chief - Innovation & Creativy, aquí la descripción del rol

¿Interesado en publicar en nuestro newsletter? Completa este formulario